Ngày 05/08/2021, Apple giới thiệu tính năng an toàn mới trong các thiết bị iOS, iPadOS, watchOS và macOS giúp hạn chế trẻ em tiếp xúc với các nội dung, hình ảnh nhạy cảm (Child Sexual Abuse Material-CSAM) ở Mĩ.

IPhone dự định quét, kiểm tra tất cả hình ảnh được người dùng chia sẻ qua mọi thiết bị Apple để tìm nội dung nhạy cảm đối với trẻ em được tải lên iCloud Photos.

IPhone sử dụng machine learning để phân tích, kiểm tra các tin nhắn và cảnh báo cho các phụ huynh nếu tìm thấy những bức ảnh lạm dụng trẻ em trên các tài khoản thiết bị của trẻ vị thành niên (dưới 13 tuổi).

Apple cho biết "Tính năng này được thiết kế để Apple không có quyền truy cập vào các tin nhắn nhưng vẫn có thể tự động kiểm tra." Tính năng này được gọi là Communication Safety, là một cài đặt tùy chọn chỉ được kích hoạt bởi phụ huynh thông qua tính năng Family Sharing.

Apple cũng có kế hoạch cập nhật Siri và Search để hạn chế người dùng thực hiện tìm kiếm các chủ đề liên quan đến CSAM bằng cách cảnh báo tìm kiếm này là độc hại.

Cách phát hiện nội dung nhạy cảm đối với trẻ em

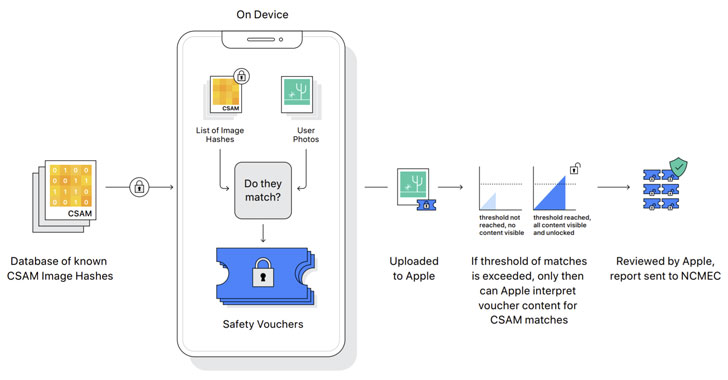

Các hình ảnh được phát hiện bằng cách đối sánh mã băm của hình ảnh trên thiết bị với các mã băm hình ảnh CSAM đã biết trong cơ sở dữ liệu do Trung tâm quốc gia về trẻ em mất tích và bị bóc lột (NCMEC) và các tổ chức an toàn trẻ em khác cung cấp trước khi nó được tải lên cloud. Tính năng này chỉ hoạt động khi tính năng chia sẻ ảnh iCloud được bật.

Apple dự kiến sẽ đặt ra một ngưỡng về hình ảnh lạm dụng, nếu trên các tài khoản iCloud Photos phát hiện CSAM vượt qua ngưỡng này sẽ tiến hành kiểm tra thủ công để xác nhận kết quả phát hiện có chính xác không. Nếu đúng sẽ vô hiệu hóa tài khoản của người dùng, báo cáo nội dung nhạy cảm cho NCMEC và chuyển cho cơ quan thực thi pháp luật.

Vấn đề về quyền riêng tư

Ý tưởng về CSAM của Apple đã khiến các chuyên gia bảo mật lo lắng rằng nó có thể được sử dụng cho mục đích khác như phát hiện các nội dung có liên quan đến chính trị và có thể xâm phạm quyền riêng tư trên các thiết bị.

Edward Snowden cho biết: “mặc dù dự án có mục đích tốt, nhưng những gì Apple đang triển khai là thực hiện giám sát hàng loạt”.

Giáo sư mật mã của Đại học Johns Hopkins và chuyên gia bảo mật Matthew Green cho rằng: "mã hóa là một công cụ mạnh mẽ cung cấp quyền riêng tư nhưng không thể thực sự đảm bảo hoàn toàn về quyền riêng tư trong khi vẫn khảo sát mọi hình ảnh mà mọi người gửi."

Apple sử dụng các phương pháp băm hình ảnh tương tự như Google, Twitter, Microsoft, Facebook, and Dropbox đã làm để tìm kiếm và gắn nhãn nội dung nhạy cảm tiềm ẩn trong các tệp iCloud và hình ảnh được gửi qua email. Hành động của Apple đã làm mới các cuộc tranh luận về điểm yếu của mã hóa, và cũng gây ra nhiều tranh luận về vấn đề quyền riêng tư và chính sách trong thời đại kỹ thuật số.

Nguồn: thehackernews.com.